open-webui部署

docker部署

1.添加国内镜像源(不然下载很慢)

# 打开docker镜像配置文件

vi /etc/docker/daemon.json

# 配置如下

{

"registry-mirrors": [

"https://mirror.ccs.tencentyun.com",

"https://docker.registry.cyou",

"https://docker-cf.registry.cyou",

"https://dockercf.jsdelivr.fyi",

"https://docker.jsdelivr.fyi",

"https://dockertest.jsdelivr.fyi",

"https://mirror.aliyuncs.com",

"https://dockerproxy.com",

"https://mirror.baidubce.com",

"https://docker.m.daocloud.io",

"https://docker.nju.edu.cn",

"https://docker.mirrors.sjtug.sjtu.edu.cn",

"https://docker.mirrors.ustc.edu.cn",

"https://mirror.iscas.ac.cn",

"https://docker.rainbond.cc",

"https://ghcr.io",

"https://ghcr.nju.edu.cn"

]

}

2.启动

# 需要将api.openai.com映射到本地,不然无法正常访问页面(可以直接访问的话不需要这部分)

# --add-host api.openai.com:127.0.0.1

# 端口可以更改

docker run -d --add-host api.openai.com:127.0.0.1 -p 10080:10080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:ollama

3.访问登录地址

# 反向代理127.0.0.1:10080

http://ai.emptycity.top/

# 本地可以直接 http://localhost:10080

4.注册管理员帐号

5.登录

大模型API接入

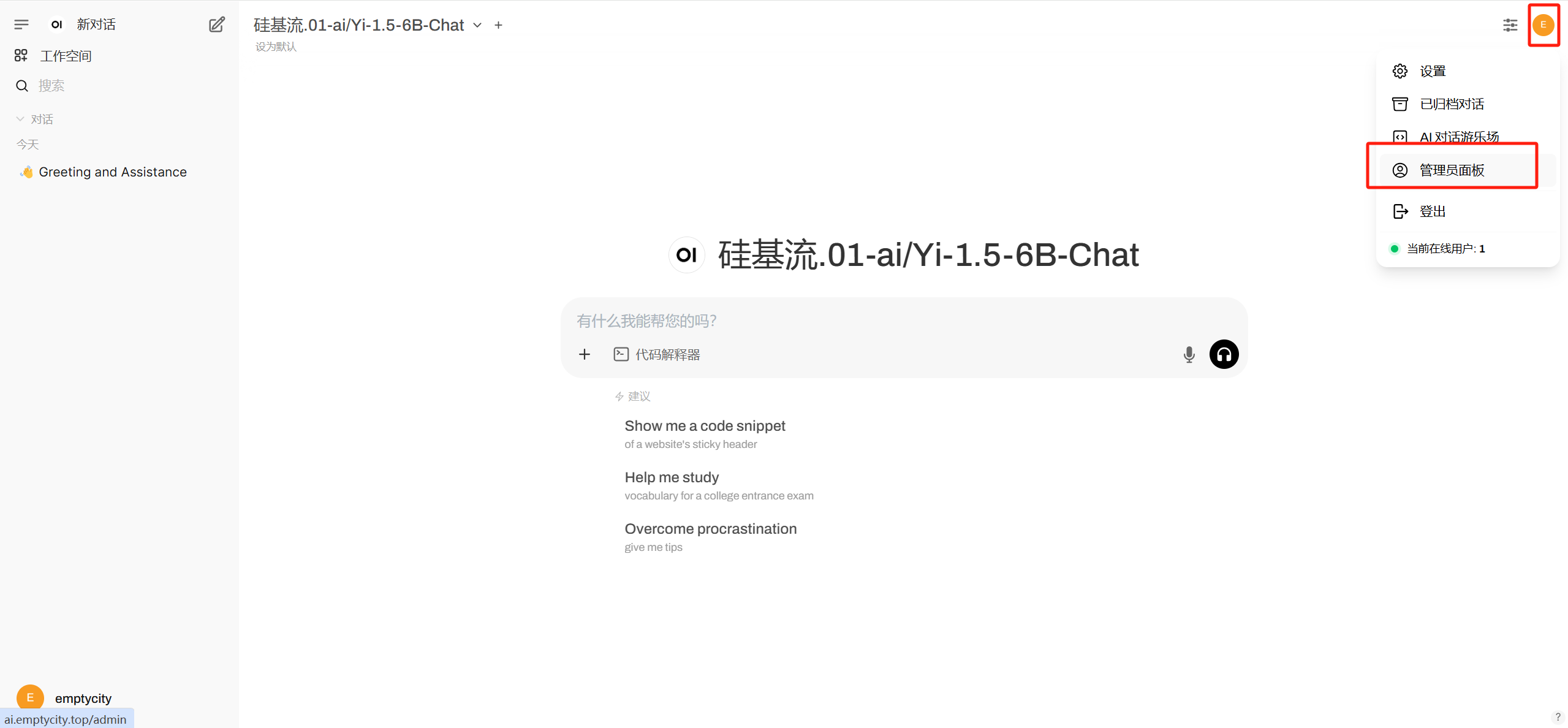

1.进入管理员面板

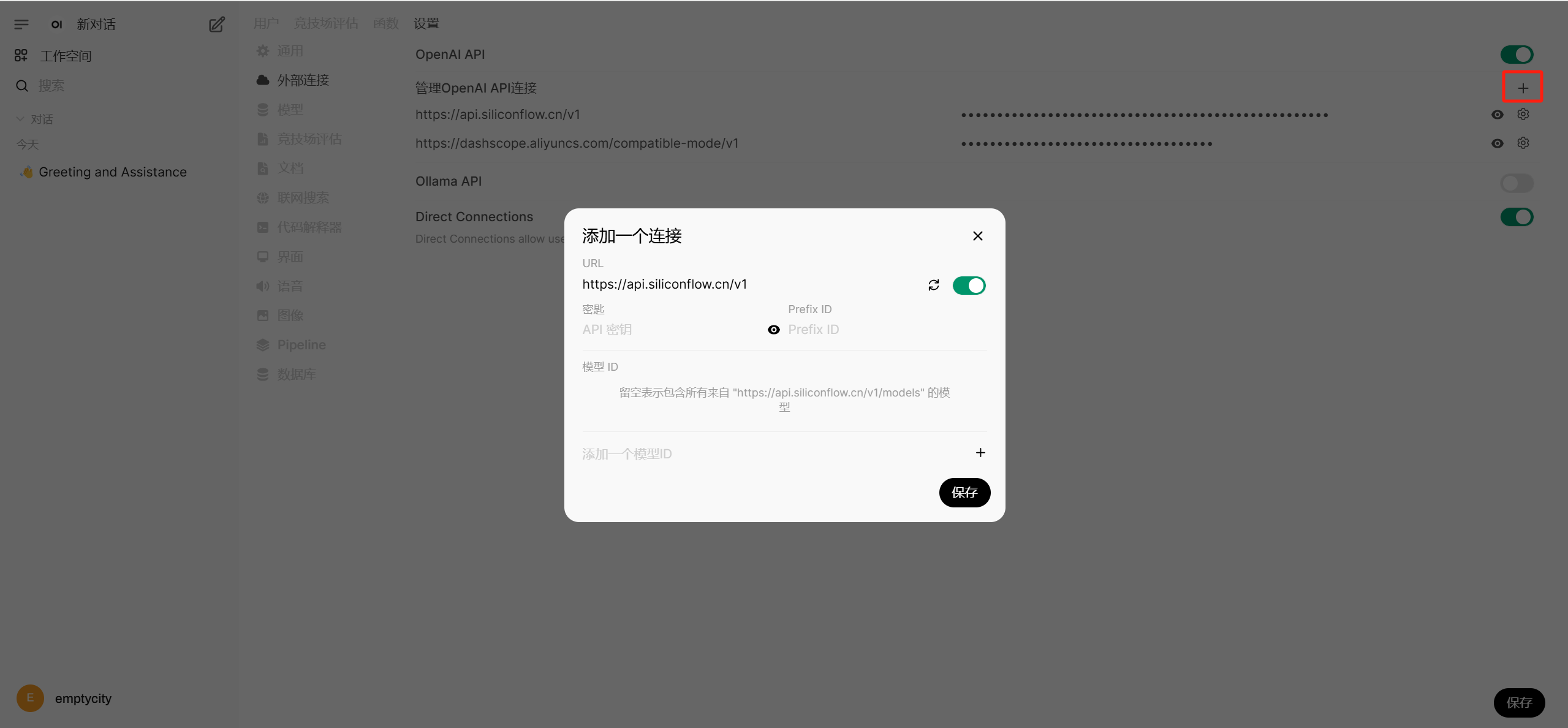

2.进入设置》外部链接

3.删除默认的api.openai.com,添加需要对接的api

4.以硅基流动api为例,输入api地址以及密钥即可

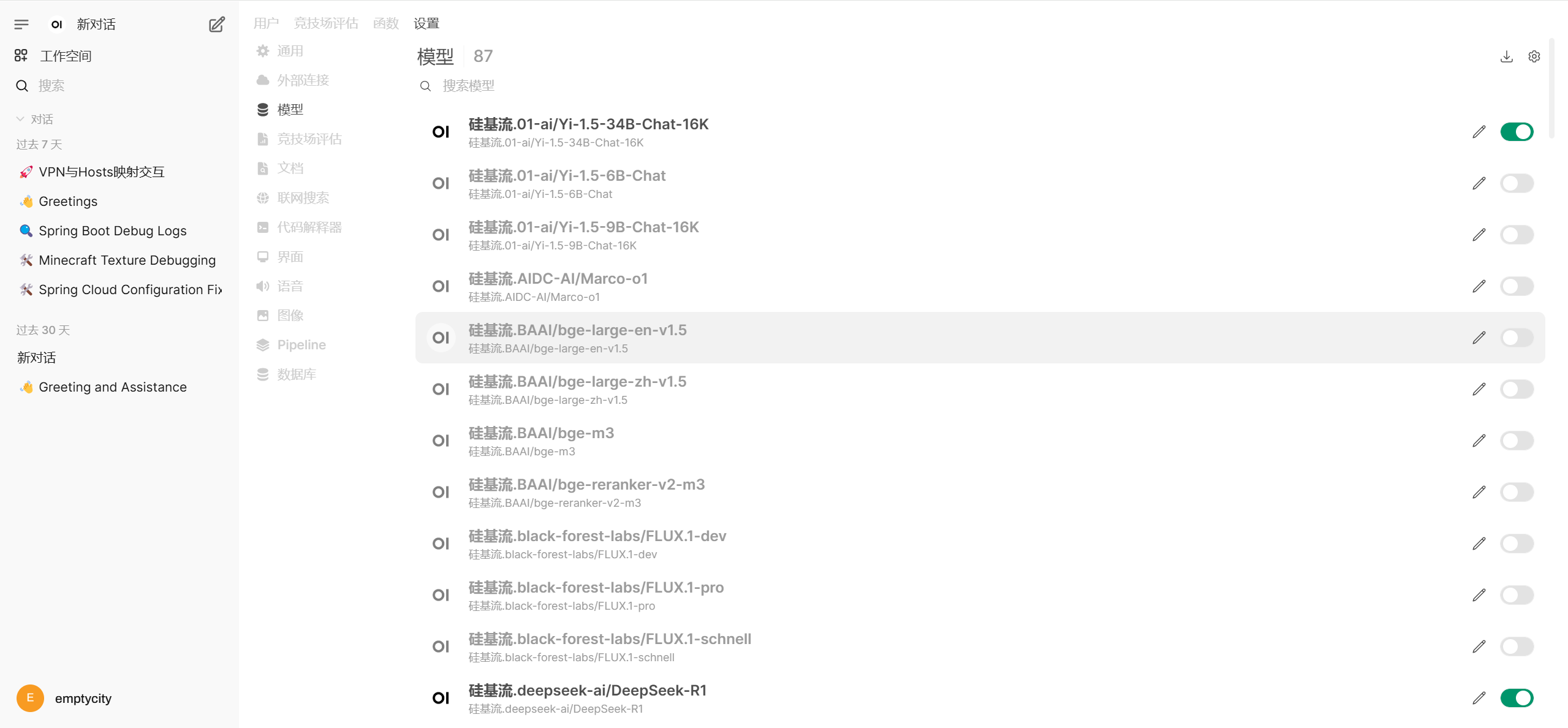

5.可以在 设置》模型 处管理已接入的模型